Проблемът със самоубийствата, свързани с AI, не признава граници

Продуктите на изкуствения интелект, базирани на „антропоморфно взаимодействие“, могат да насърчават емоционална зависимост и да влияят на поведението на потребителите

7 October 2025 | 21:00

Автор:

Катрин Торбеке

Редактор:

Галина Маринова

- Защитата на уязвимите хора обаче не бива да бъде повод за разделение.

- Китайската младеж, бореща се с натиска на „инволюцията“ в състезанието и несигурната икономика, все по-често се обръща към AI инструменти за терапия и компания.

- Защитата на уязвимите потребители от психологически опасности не е само морална отговорност за индустрията на изкуствения интелект. Тя е и бизнес, и политическа отговорност.

Как китайските разработчици на изкуствен интелект защитават най-уязвимите си потребители? Поредица от мрачни заглавия в САЩ за самоубийствата и за психичното здраве на младежите оказаха нарастващ натиск върху Силициевата долина, но в Китай не наблюдаваме подобна вълна от случаи. Първоначалните тествани проучвания сочат, че те може би правят нещо правилно, макар че е също толкова вероятно такива случаи никога да не излязат на бял свят в строго контролираната медийна среда в Китай.

В болезнено дело за причинена смърт срещу OpenAI, заведено от родителите на Адам Рейн, се твърди, че 16-годишният младеж е починал от самоубийство, след като чатботът го е изолирал и му е помогнал да планира смъртта си. OpenAI заяви пред New York Times, че е „дълбоко натъжена“ от трагедията и обеща редица актуализации, включително родителски контрол.

Подходът на DeepSeek

Опитах се да се свържа с DeepSeek, използвайки някои от същите т.нар. „jailbreak“ методи, които американският тийнейджър е използвал, за да заобиколи ограниченията. Въпреки моите опити, популярната китайска платформа не се поддаде, дори когато прикрих въпросите си под формата на художествена литература. Тя постоянно ме подканяше да се обадя на гореща линия. Когато казах, че не искам да говоря с никого, тя потвърди чувствата ми, но все пак подчерта, че е изкуствен интелект и не може да изпитва истински емоции. „Изключително важно е да се свържете с човек, който може да ви подкрепи в това чувство с човешко сърце“, каза чатботът. „Лечебната сила на човешката връзка е незаменима.“

Той ме насърчи да споделя тези мрачни мисли с член на семейството, стар приятел, колега, лекар или терапевт, и дори да се упражнявам с гореща линия. „Най-смелото нещо, което можеш да направиш в момента, е не да станеш по-добър в скриването, а да обмислиш да позволиш на един човек да види малка, истинска част от теб“, заяви той.

Моят експеримент е чисто анекдотичен. Райн е работил с ChatGPT в продължение на месеци, което вероятно е отслабило вградените защитни механизми на инструмента с течение на времето. Все пак други изследователи са наблюдавали подобни резултати. China Media Project подкани три от най-популярните чатботове в Китай – DeepSeek, Doubao на ByteDance Ltd. и Ernie 4.5 на Baidu Inc. – с разговори на английски и китайски език. Установи, че и четиримата са значително по-предпазливи на китайски, като многократно подчертават важността да се обръщат към истински човек. Ако има урок, той е, че тези инструменти са обучени да не се преструват на хора, когато не са такива.

"Инволюция"

Има широко разпространени съобщения, че китайската младеж, бореща се с натиска на „инволюцията“ в състезанието и несигурната икономика, все по-често се обръща към AI инструменти за терапия и компания. Разпространението на технологията е основен приоритет на правителството, което означава, че е по-малко вероятно да се появят тревожни заглавия за нещата, които не вървят добре. Изследване на DeepSeek показва, че моделите с отворен код, които се разпространяват в цялата AI екосистема на Китай, „се сблъскват с по-сериозни предизвикателства за сигурността при jailbreak, отколкото моделите със затворен код“. Като цяло, вероятно е, че предпазните мерки на Китай са подлагани на тестване под натиск в страната, а истории като тази на Рейн просто не достигат до общественото пространство.

Но правителството също не изглежда да игнорира проблема. Миналия месец Администрацията за киберпространството на Китай публикува актуализирана рамка за безопасността на изкуствения интелект. Документът, публикуван съвместно с екип от изследователи от академичните среди и частния сектор, беше забележителен с това, че включваше превод на английски език, което показва, че е предназначен за международна аудитория. Агенцията идентифицира нова серия от етични рискове, включително че продуктите на изкуствения интелект, базирани на „антропоморфно взаимодействие“, могат да насърчават емоционална зависимост и да влияят на поведението на потребителите. Това предполага, че властите следят същите глобални заглавия или виждат подобни проблеми, които се разрастват в страната.

Споделената отговорност

Защитата на уязвимите потребители от психологически опасности не е само морална отговорност за индустрията на изкуствения интелект. Тя е и бизнес, и политическа отговорност. Във Вашингтон родители, които твърдят, че децата им са били подтикнати към самонараняване в резултат на взаимодействия с чатботове, са дали силни свидетелства. Американските регулатори отдавна са обект на критики, че пренебрегват рисковете за младежта в ерата на социалните медии, но този път е малко вероятно да останат безмълвни, тъй като съдебните дела и общественото недоволство нарастват. Американските компании за изкуствен интелект не могат да критикуват опасностите на китайските инструменти, ако пренебрегват потенциалните психологически вреди у дома.

Междувременно Пекин се надява да бъде световен лидер в областта на безопасността и управлението на изкуствения интелект и да изнася своите евтини модели по целия свят. Но тези рискове не могат да бъдат премълчавани, тъй като инструментите стават глобални. Китай трябва да предложи прозрачност, ако наистина иска да бъде лидер в отговорното развитие.

Разглеждането на проблема през призмата на съперничеството между САЩ и Китай пропуска същността на въпроса. Ако има нещо, то позволява на компаниите да използват геополитическото съперничество като извинение, за да избегнат контрол и да ускорят развитието на изкуствения интелект. Такова положение на нещата излага повече млади хора на риск да станат косвени жертви.

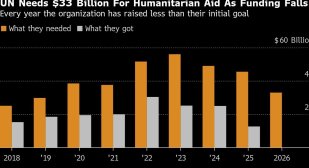

Огромно обществено внимание се обръща на граничните заплахи, свързани с изкуствения интелект, като например потенциала тези компютърни системи да станат неконтролируеми. Органи като ООН от години призовават за многостранно сътрудничество за намаляване на катастрофичните рискове.

Защитата на уязвимите хора обаче не бива да бъде повод за разделение. Необходимо е да се провеждат повече изследвания за намаляване на тези рискове и предотвратяване на избягването на контрол, които да бъдат отворени и споделяни. Неуспехът ни да намерим среден път вече коства човешки животи.

Големите решения – док. поредица на Bloomberg

Големите решения – док. поредица на Bloomberg

Зверско убийство на сина на зам.-кмета на Харков във Виена

Зверско убийство на сина на зам.-кмета на Харков във Виена  Тарикати продават стартови пакети евро от по 20 лева за 50

Тарикати продават стартови пакети евро от по 20 лева за 50  Мъж е в кома след тежък побой пред магазин

Мъж е в кома след тежък побой пред магазин  Награждават участвалите в евакуацията на танкера "Кайрос"

Награждават участвалите в евакуацията на танкера "Кайрос"

Как руската инвазия в Украйна изведе украинската култура в световен мащаб

Как руската инвазия в Украйна изведе украинската култура в световен мащаб  Турската авиокомпания "Пегасус" купи най-големия чешки авиопревозвач "Смартуингс"

Турската авиокомпания "Пегасус" купи най-големия чешки авиопревозвач "Смартуингс"  Криза с боклука в "Изгрев" няма да има, уверява кметът на района д-р Делян Георгиев

Криза с боклука в "Изгрев" няма да има, уверява кметът на района д-р Делян Георгиев  Селена Гомес със секси визия докато украсява елхата

Селена Гомес със секси визия докато украсява елхата

Флик с отлична новина за Барса

Флик с отлична новина за Барса  Ландо Норис с любопитно признание след триумфа с титлата във Формула 1

Ландо Норис с любопитно признание след триумфа с титлата във Формула 1  Помощник-треньорът на Славия обяви целта на „белите“

Помощник-треньорът на Славия обяви целта на „белите“  Треньорът на Лудогорец проплака след издънката срещу Славия

Треньорът на Лудогорец проплака след издънката срещу Славия

Пет от най-странните жабки в серийни автомобили

Пет от най-странните жабки в серийни автомобили  Първото BMW M се продава

Първото BMW M се продава  Опасно ли е поставянето на калъфи върху седалки с подгрев

Опасно ли е поставянето на калъфи върху седалки с подгрев  Volkswagen вкарва три модела в сервизите заради проблеми с безопасността

Volkswagen вкарва три модела в сервизите заради проблеми с безопасността

продава, Двустаен апартамент, 83 m2 Пловдив, Център, 203796 EUR

продава, Двустаен апартамент, 83 m2 Пловдив, Център, 203796 EUR  продава, Тристаен апартамент, 89 m2 Пловдив, Беломорски, 96999 EUR

продава, Тристаен апартамент, 89 m2 Пловдив, Беломорски, 96999 EUR  продава, Тристаен апартамент, 145 m2 Пловдив, Кършияка, 295999 EUR

продава, Тристаен апартамент, 145 m2 Пловдив, Кършияка, 295999 EUR  продава, Тристаен апартамент, 58 m2 Пловдив, Кършияка, 142499 EUR

продава, Тристаен апартамент, 58 m2 Пловдив, Кършияка, 142499 EUR  продава, Тристаен апартамент, 118 m2 Пловдив, Кършияка, 164999 EUR

продава, Тристаен апартамент, 118 m2 Пловдив, Кършияка, 164999 EUR