Социалните медии не могат вечно да крият проблемите си зад изкуствения интелект

Системите за изкуствен интелект са трудни за дешифриране, но пробив в сферата не е невъзможен

Обновен: 1 August 2022 | 20:47

Автор: Николета Рилска

Определено има добри причини да се разкрият тайните на гигантите, предоставящи платформи за социални медии. През последното десетилетие правителствата гледаха безпомощно как техните демократични процеси са нарушавани от дезинформация и реч на омразата в сайтове като Facebook на Meta Platforms, YouTube на Alphabet и Twitter. Сега някои правителства готвят възмездие, пише Парми Олсън за Bloomberg.

През следващите две години Европа и Великобритания ще въведат закони, които ще овладеят проблемното съдържание, чието вирусно разпространение позволиха технологичните гиганти. Досега имаше много скептицизъм относно способността да се надникне под повърхността на компании като Facebook. Регулаторите не разполагат с техническата експертиза, работната сила и заплатите, с които Big Tech могат да се похвалят. Има и още един технически проблем: системите за изкуствен интелект, които технологичните фирми използват, са изключително трудни за дешифриране.

Но скептиците трябва да имат едно наум. Разработват се нови технологии, които ще направят изследването на тези системи по-лесно. Т. нар. "проблем на черната кутия" на изкуствения интелект не е толкова непроницаем, колкото мнозина си мислят.

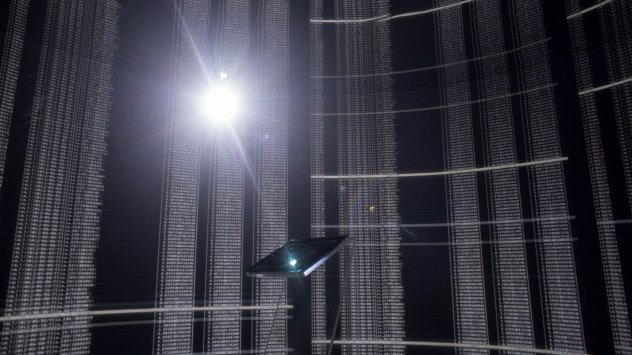

Изкуственият интелект стои зад повечето от действията, които виждаме във Facebook или YouTube. Най-вече това се отнася за избора на публикации, които се представят на даден потребител, както и при видеата – всичко това цели да накара хората да прекарват повече време в приложението. Множество данни се използват за обучение на изкуствения интелект, което му позволява да прави прогнози, донякъде подобни на човешките. Трудната част за инженерите е да разберат как изкуственият интелект взема решения. Оттук идва и концепцията за черната кутия.

Подобен парадокс засяга моделите за машинно обучение. Понякога те дават правилен отговор, но дизайнерите им често не могат да обяснят как. Появява се малка, но развиваща се индустрия, която следи как работят тези системи. Нейната най-популярна задача е да подобри производителността на моделите, използващи изкуствен интелект. Компаниите, които ги използват, също искат да се уверят, че техният изкуствен интелект не взема пристрастни решения, когато, например, преглежда кандидатури за работа или отпуска заеми.

Ето пример как работи един от тези стартъпи. Финансова компания наскоро използва израелския стартъп Aporia, за да провери дали кампания за привличане на студенти работи. Aporia установява, че системата за изкуствен интелект на компанията всъщност прави грешки - отпуска заеми на някои млади хора, на които не би трябвало, или ненужно лишава от заеми други. Когато Aporia разглежда казуса по-подробно установява и проблема: делът на студентите при данните, използвани за обучаването на изкуствения интелект на компанията, е по-малко от 1%.

Според говорител на Европейската комисия предстоящият Закон за цифровите услуги ще изисква онлайн платформите да се подлагат на одити веднъж годишно, за да се оцени колко „рискови“ са техните алгоритми за гражданите. Това понякога може да принуди фирмите да предоставят безпрецедентен достъп до информация, която мнозина смятат за търговска тайна: код, данни за обучение и регистрационни файлове на процеси.

Дори европейските регулатори да не могат да ровят в кодовете на Facebook или YouTube, както и в алгоритмите, които решават какви публикации да се препоръчват, все пак могат да направят много.

Маноел Рибейро, докторант на Швейцарския федерален технологичен институт, публикува проучване през 2019 г., в което той и негови колеги проследяват как някои посетители на YouTube са били радикализирани от крайнодясно съдържание. Те правят това, без да им е нужен достъп до код. Изследователите просто са прегледали коментарите на сайта, за да видят към какви канали са се насочили потребителите с течение на времето. Това е като проследяване на дигитални отпечатъци – трудоемък процес, но в крайна сметка разкрива как част от потребителите на YouTube са били примамвани в специфични канали чрез т.нар. „инфлуенсъри“.

Проучването на Рибейро е част от по-широк набор от изследвания, които проследяват психологическите странични ефекти на Facebook или YouTube, без да е необходимо да се разбират техните алгоритми. Въпреки че предлагат сравнително повърхностни перспективи за това как работят платформите на социалните медии, те все пак могат да помогнат на регулаторите да наложат по-широки изисквания на платформите.

Това е коренно различна перспектива от потайността, при която технологичните гиганти можеха да работят досега. И ще включва както нови технологии, така и нови политики. За регулаторите това може да е печеливша комбинация.