Как фирмите за изкуствен интелект се справят с "дълбоките" фалшификати

Компаниите за изкуствен интелект нямат регулаторно задължение да разкриват подробности за своите практики за безопасност

Редактор: Галина Маринова

Когато хората се притесняват от изкуствения интелект, това се дължи не само на това, което виждат в бъдещето, но и на това, което помнят от миналото - по-специално токсичните ефекти на социалните медии. В продължение на години дезинформацията и речта на омразата избягваха полицейските системи на Facebook и Twitter и се разпространяваха по целия свят. Сега дълбоките фалшификати проникват в същите платформи и макар Facebook все още да е отговорен за начина, по който се разпространяват лошите неща, компаниите с изкуствен интелект, които ги създават, също имат роля в почистването. За съжаление, както и фирмите за социални медии преди тях, те извършват тази работа при закрити врати.

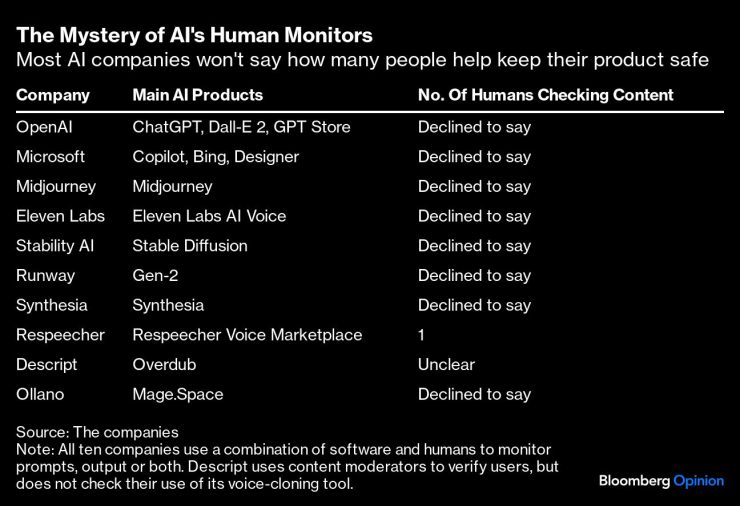

Обърнах се към десетина фирми за генеративен ИИ, чиито инструменти могат да генерират фотореалистични изображения, видеоклипове, текст и гласове, за да попитам как се уверяват, че техните потребители спазват правилата им. Десет от тях отговориха, като всички потвърдиха, че използват софтуер, за да следят какво създават техните потребители, а повечето заявиха, че имат и хора, които проверяват тези системи. Почти никой от тях не се съгласи да разкрие колко хора са натоварени с контрола на тези системи.

И защо да го правят? За разлика от други индустрии като фармацевтичната, автомобилната и хранителната, компаниите за изкуствен интелект нямат регулаторно задължение да разкриват подробности за своите практики за безопасност. Те, подобно на фирмите за социални медии, могат да бъдат толкова мистериозни по отношение на тази работа, колкото искат, и това вероятно ще остане така през следващите години. В предстоящия европейски закон за изкуствения интелект се изтъкват "изисквания за прозрачност", но не е ясно дали той ще принуди фирмите за изкуствен интелект да проверяват практиките си за безопасност по същия начин, както го правят производителите на автомобили и храни.

За тези други индустрии бяха необходими десетилетия, за да се приемат строги стандарти за безопасност. Но светът не може да си позволи инструментите на ИИ да имат свободна воля за толкова дълго време, когато те се развиват толкова бързо. Midjourney наскоро актуализира софтуера си, за да генерира изображения, които са толкова фотореалистични, че могат да покажат порите на кожата и бръчиците на политиците. В началото на годината на големи избори, когато почти половината свят ще отиде до урните, един пропуск в нормативната уредба означава, че съдържанието, генерирано от ИИ, може да има опустошително въздействие върху демокрацията, правата на жените, творческите изкуства и др.

Ето няколко начина за справяне с проблема. Един от тях е да накараме компаниите за ИИ да бъдат по-прозрачни по отношение на своите практики за безопасност, което започва със задаването на въпроси. Когато се обърнах към OpenAI, Microsoft, Midjourney и други, зададох простички въпроси: как прилагате правилата си, използвайки софтуер и хора, и колко хора вършат тази работа?

Повечето от тях бяха готови да споделят няколко абзаца подробности за процесите си за предотвратяване на злоупотреби (макар и на неясен език за връзки с обществеността). OpenAI например има два екипа от хора, които помагат за преквалификацията на моделите на изкуствения интелект, за да ги направят по-безопасни или да реагират на вредни резултати. Компанията, която стои зад спорния генератор на изображения Stable Diffusion, заяви, че използва "филтри" за безопасност, за да блокира изображенията, които нарушават правилата ѝ, а човешки модератори проверяват подсказките и изображенията, които са маркирани.

Тайната на човешките наблюдатели на изкуствения интелект. Повечето компании за изкуствен интелект няма да кажат колко души помагат за поддържането на безопасността на техните продукти

Както можете да видите от таблицата по-горе обаче, само няколко компании разкриха колко хора работят за надзора на тези системи. Мислете за тези хора като за вътрешни инспектори по безопасността. В социалните медии те са известни като модератори на съдържание и играят предизвикателна, но изключително важна роля в двойната проверка на съдържанието, което алгоритмите на социалните медии отбелязват като расистко, женомразко или изпълнено с насилие. Във Facebook работят над 15 000 модератори, които поддържат целостта на сайта, без да потискат свободите на потребителите. Това е деликатен баланс, с който хората се справят най-добре.

Разбира се, с вградените си филтри за безопасност повечето инструменти за изкуствен интелект не изхвърлят токсично съдържание, каквото хората правят във Facebook. Но те все пак биха могли да се направят по-безопасни и по-надеждни, ако наемат повече човешки модератори. Хората са най-добрият предпазен механизъм при липсата на по-добър софтуер за улавяне на вредно съдържание, който досега се оказва недостатъчен.

Порнографски deepfakes на Тейлър Суифт и гласови клонинги на президента Джо Байдън и други международни политици се разпространиха като вирус, и това са само няколко примера, които подчертават, че AI и технологичните компании не инвестират достатъчно в безопасността. Признаваме, че наемането на повече хора, които да им помагат да прилагат правилата си, е като да вземеш повече кофи с вода, за да потушиш пожар в къща. Това може да не реши целия проблем, но ще го подобри временно.

"Ако сте стартъп, който създава инструмент с генеративен компонент на изкуствения интелект, наемането на хора в различни моменти от процеса на разработка е нещо средно между много разумно и жизненоважно", казва Бен Уайтлоу, основател на Everything in Moderation, бюлетин за онлайн безопасност.

Няколко фирми, работещи с ИИ, признават, че разполагат само с един или двама човешки модератори. Фирмата за генериране на видеоклипове Runway заяви, че нейните собствени изследователи са свършили тази работа. Descript, която произвежда инструмент за клониране на гласове, наречен Overdub, заяви, че проверява само извадка от клонирани гласове, за да се увери, че те съответстват на декларацията за съгласие, прочетена от клиентите. Говорителката на стартъпа твърди, че проверката на работата им би навлязла в личния им живот.

Компаниите за изкуствен интелект разполагат с несравнима свобода да извършват работата си в тайна. Но ако искат да си осигурят доверието на обществеността, регулаторните органи и гражданското общество, в техен интерес е да отдръпнат повече завесата, за да покажат как точно прилагат своите правила. Наемането на още хора също не би било лоша идея. Прекаленото съсредоточаване върху надпреварата да направим изкуствения интелект "по-интелигентен", така че фалшивите снимки да изглеждат по-реалистични, текстът - по-плавен, а клонираните гласове - по-убедителни, заплашва да ни вкара още по-дълбоко в един опасен и объркващ свят. По-добре е да увеличим обема и да разкрием стандартите за безопасност сега, преди всичко да стане много по-трудно.